海战场越来越成为大国军事对抗的主战场, 海战场目标搜寻是海上作战的重要构成要素, 是待救军事人员的最后一道希望, 随着以人为本理念的深入, 海上搜救问题得到越来越多的关注。当遇险目标位置不明时, 须进行海上搜寻。海上搜寻在整个搜救过程中是最昂贵、最危险和最复杂的部分, 也是发现和救助遇险目标的唯一途径。海战场搜救行动成功与否的关键在于搜寻预案的制定, 目前实际搜救过程中搜寻方案的制定过多依赖于主观决策者的主观判断和历史的经验指导, 行动的组织存在一定的盲目性, 搜寻任务规划缺乏系统性。因此, 研究定量化的搜寻预案设计方法与技术, 建立科学、高效、易实施的海战场搜寻方法至关重要[1 ] 。

在调研过程中发现, 海战场待搜寻目标具有存活时间短、待搜寻区域广、探测概率低、漂流轨迹难以预测等特征, 要求目标搜寻规划方法必须能够快速响应, 且支持实时规划[2 ] 。但是当前我国海战场目标搜寻能力距离国际先进水平尚有一定差距[3 ] 。在实际搜救过程中, 针对未知位置的海上目标搜寻问题, 大多仍然采用机械的覆盖搜寻方法, 效率较低, 且难以准确量化实时调整搜寻方案。在研究方面, 传统的目标搜寻规划求解方法, 如精确优化算法、启发式算法、元启发式算法等只能针对明确的搜寻场景进行求解, 而无法应对搜寻态势实时变化的情形[4 ] 。且由于无人机的快速发展, 传统搜寻模式和研究方法均不太适用于基于无人机的灵活多变的搜寻模式需求。而强化学习是一种不断与环境交互反馈, 调整自身策略以应对环境变化的动态规划方法, 得到了多种实际场景的应用验证[5 -8 ] , 适用于海战场目标搜寻路径规划问题的优化求解。因此, 可结合强化学习等智能方法拓展搜寻方案的制定方法, 设计海战场目标搜寻的快速响应算法, 提高搜寻效率, 进而提升海上作战效能。

然而, DQN基于使用单个价值网络的训练效率较低, 且完整的分布信息很大程度上被丢失[8 ] 。为了解决DQN算法本身存在的不足, 后续研究者对其进行了大量改进, 如优先Q网络[11 ] 、双Q网络[12 ] 、竞争Q网络结构[13 ] 等。近年, 也有学者提出分布式Q学习算法[14 ] 、噪声网络结构[15 ] 。但是以上这些算法都可以在某个方面提升DQN的性能, 而且都是基于同一个网络框架。Hessel等将上述所有方法进行整合, 提出通用性很强的Rainbow算法[16 ] , 引入多步学习机制[17 -18 ] , 可以在训练前期更准确地估计目标价值以加快训练速度, 在学习效率和学习效果上都优于其他算法[19 ] 。

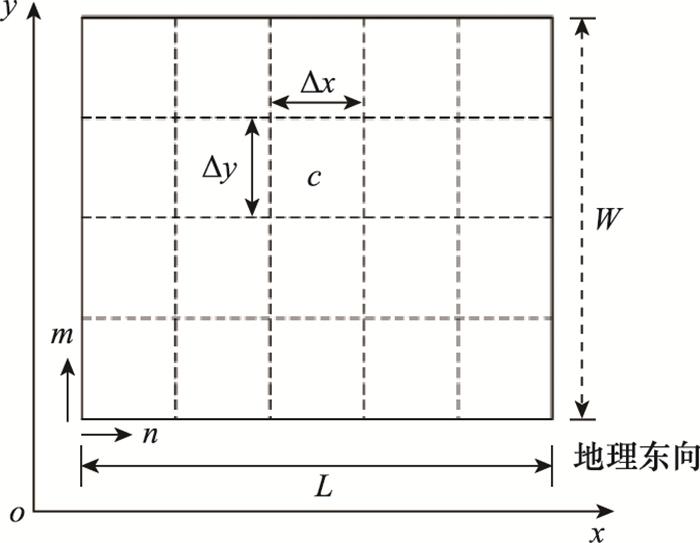

将任务区域E划分成L x L y 图 1 所示。每个网格都是独立的, 将每个网格的中心点坐标作为该网格的位置坐标。假设初始先验信息已知, 每个栅格(m , n )赋予一定的目标包含概率(probability of contain, POC)初始值p mn [20 ] , (m , n )的取值范围为m ∈{1, 2, …, L x n ∈{1, 2, …, L y

图1

搜寻地图形式化描述示意图

Fig.1

Search map formal description schematic

当无人机完成对(m , n )区域的搜寻后但未搜寻到目标时, 可基于贝叶斯原理更新目标存在于各个子区域的后验概率p ′mn p ′mn m , n )的搜寻且未搜寻到目标的条件下, 目标仍存在于(m , n )区域内的概率; 若(m , n )未被无人机搜寻, 此时p ′mn m , n )的概率。p ′mn

海洋监测中心通常基于蒙特卡罗随机粒子法进行漂流模拟得到海上遇险目标的POC矩阵, 并利用栅格法将待搜寻海域划分为若干子海域, 构建二维海洋环境栅格地图[23 ] 。将目标海域E划分成L x L y m , n )一定的初始POC值p mn m , n )都有一个属性值r , 表示子区域(m , n )的状态值, r mn t )=-1表示t 时刻以前子区域(m , n )已被无人机搜寻过, r mn t )=1表示t 时刻下无人机正处于子区域(m , n ), r mn t )=0表示t时刻及以前子区域(m , n )均未被搜寻过。

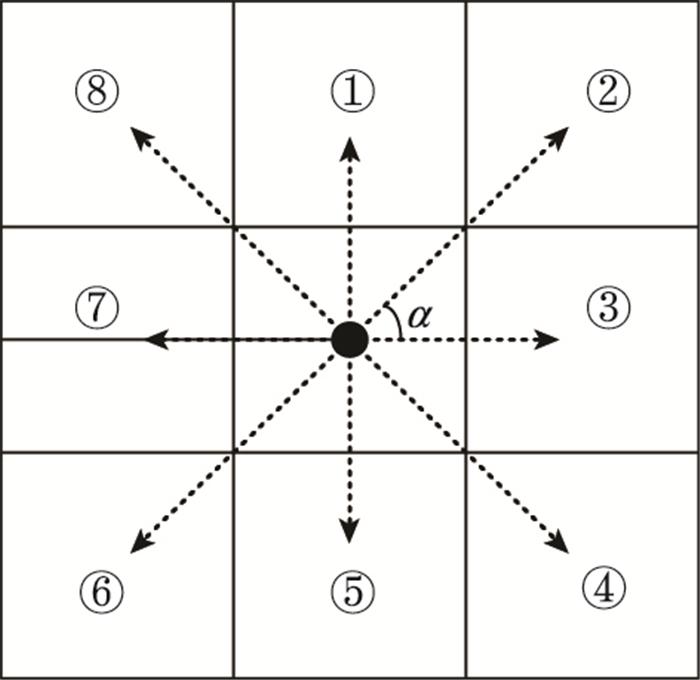

动作空间的定义会影响到无人机路径规划的效果。如图 2 所示, 将360°划分n 等份, 角度间隔α =360°/n 。假设n =8, 则α =45°。在每个决策时间点, 无人机可以采取以下行动, 比如: 左偏αi k 、直行或右偏αi k 。为方便建模, 无人机i 的动作空间可表示为ai k =[ui k ], 动作决策变量ai k ={1, 2, …, 8}, 分别表示: 上、右上、右、右下、下、左下、左和左上[24 ] 。

{R 1 , R 2 , …,RL }表示无人机在一个回合(L 步)中每一步的即时奖励集合。为尽量避免无人机重复往返同一子海域, 设置已搜寻过的海域搜寻效益奖励为r punish 。同时, 为避免无人机绕出目标海域或者进入危险区和障碍区, 同样设置越界惩罚为r punish 。随着搜寻时间的增加, 子区域(m , n )的p mn 将以一定比例g (0 < g < 1)逐渐衰减, g 值在搜寻开始前根据搜救情况具体设定, 设计第L 步的即时奖励函数[23 ] 如下:

为了增加神经网络的随机性, 鼓励智能体进行更广泛的探索, 一个有效方法是对θ θ μ σ °ξ μ σ θ ξ θ N θ ξ

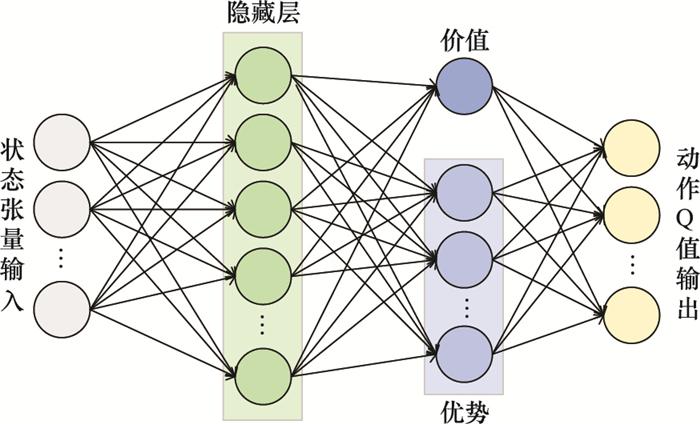

图3

对决网络结构示意图

Fig.3

Schematic diagram of dueling network structure

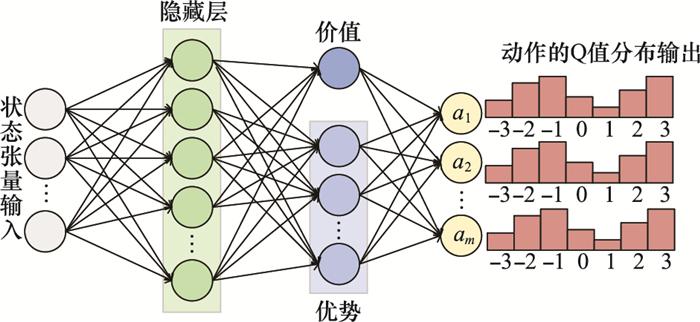

图4

值分布网络结构示意图

Fig.4

Distributional network structure diagram

假设动作空间有m 个动作, 针对每个动作的价值有N 种可能取值z z 1 , z 2 , …, z N a 则有一个概率分布向量p p 1 a p 2 a pN a ], 满足如下定义:

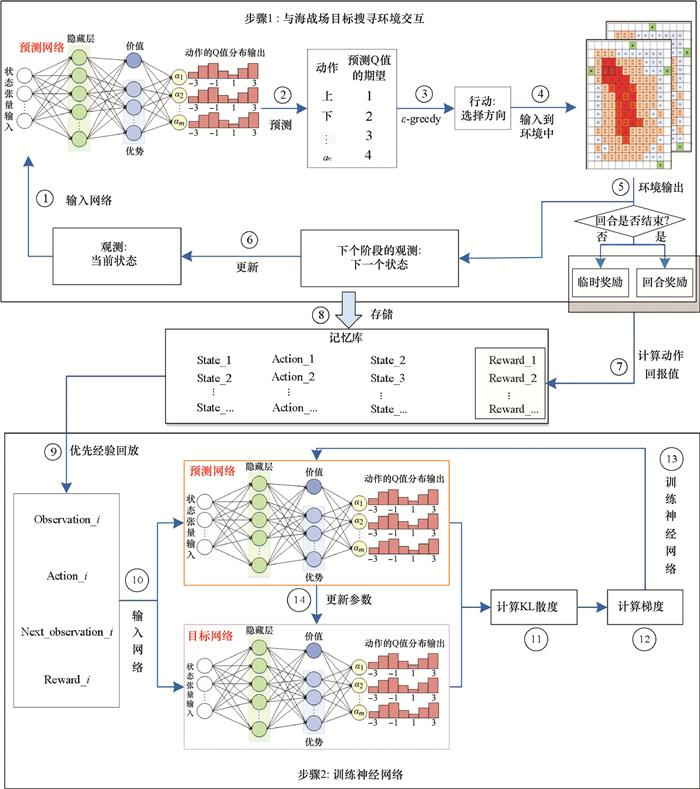

图5

海战场目标搜寻规划深度强化学习算法框架

Fig.5

Deep reinforcement learning algorithm framework for target search planning in naval battle field

本文以一次民用渔船海上事故为例, 对本文所提算法进行示例研究。2018年6月27日3时许, “碧海159”轮与木质渔船“鲁沾渔5186”在渤海湾(38°16′.0N, 118°08′.8E)处(套尔河2号浮和3号浮之间水域)发生碰撞, 商船轮舱破损进水, 宣布弃船求生, 渔船翻扣。商船上有船员23名, 渔船上9人。现场西南风4~5级, 能见度良好。3:30时,经评估, 此险情属船舶碰撞特大险情, 险情指挥由山东省海上搜救中心负责。海事部门和水产渔业部门投入了大量飞机和船舶开展了联合搜寻工作, 也协调了大型过往商船协助搜救。但是由于失事附近海域的海况开始变得恶劣, 成为搜救工作的一大难点。因此, 本文拟根据此案例背景采用所提出的算法调用无人机开展遇险目标搜寻工作。本文的训练样本数据参考北海预报中心提供的基于漂流预测模型的预测结果样本特征, 随机生成符合实际目标存在情况的概率密度值。

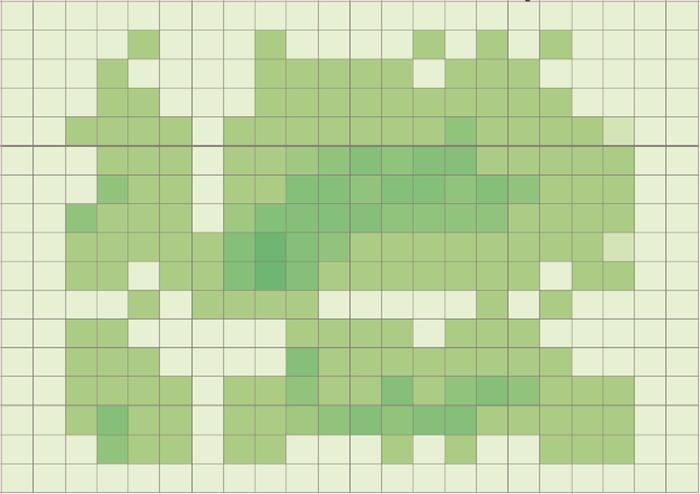

图6

搜寻区域POC预测热力图

Fig.6

POC predictive heat map of search area

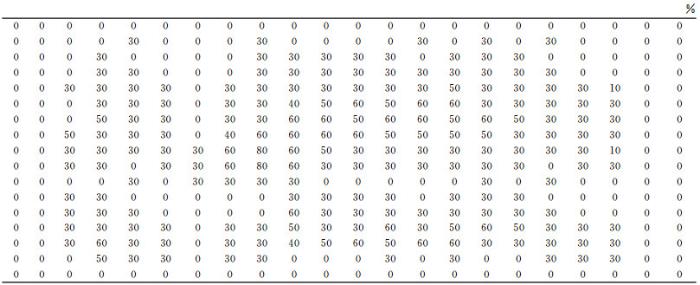

图7

搜救场景中预测得到的初始POC矩阵

Fig.7

The initial POC matrix predicted in search and rescue scenario

图8

归一化后的POC矩阵

Fig.8

Normalized POC matrix

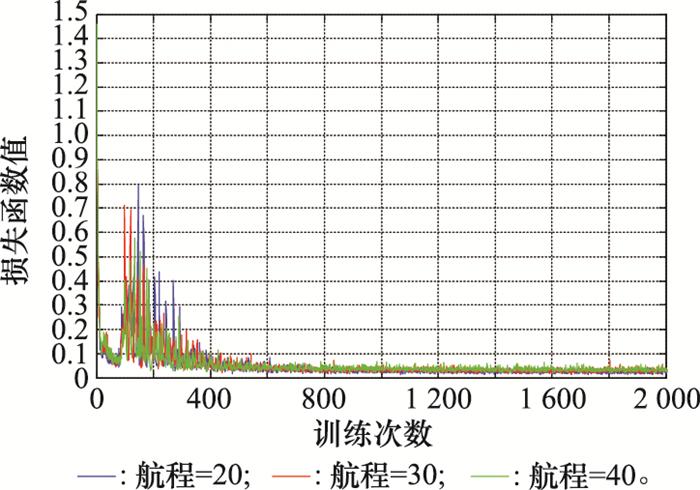

图9

不同航程下的损失值曲线

Fig.9

Loss value curve under different voyage

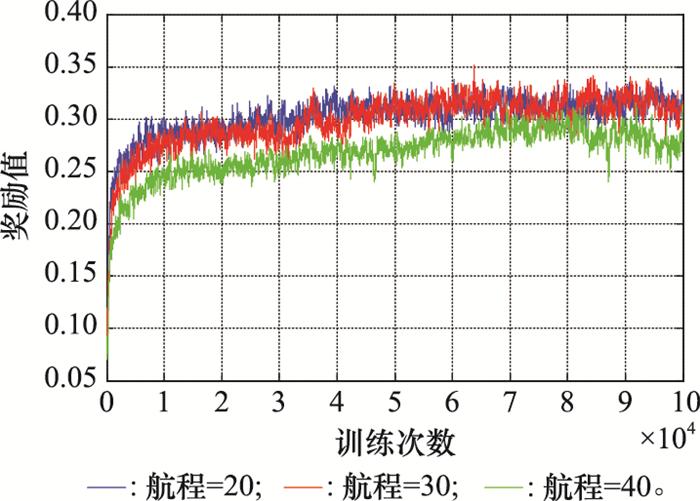

图10

不同航程下的奖励值曲线

Fig.10

Bonus curves under different voyages

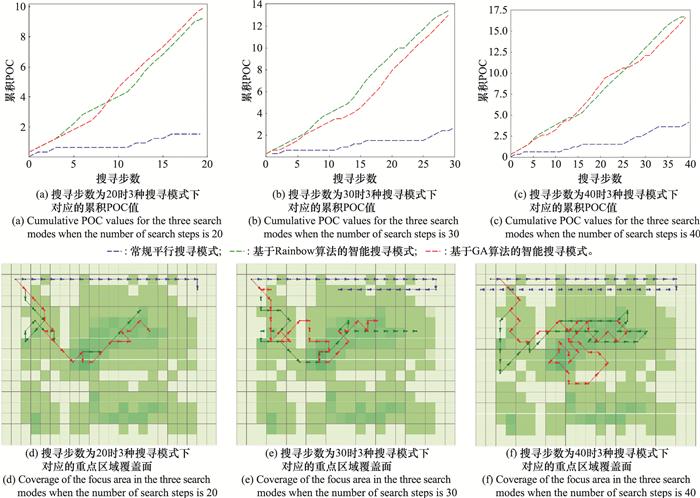

图11

不同航程下的测试结果

Fig.11

Test results under different voyages

图 11(d) ~图 11(f) 中, 蓝色箭头和线条表示基于常规平行搜寻模式产生的搜寻路径, 绿色箭头和线条表示基于Rainbow算法产生的搜寻路径, 红色箭头和线条表示基于GA产生的搜寻路径。可直观看出, 常规搜寻模式的路径较为规则, 但无法尽快搜寻到重点海域。相比之下, 基于Rainbow和GA的搜寻路径可使无人机快速覆盖目标存在概率最大的海域, 但GA无法应对动态变化的环境要素, 在实际应用中面临环境变化时往往需要重新进行优化, 而Rainbow则可以面对动态环境进行实时决策。

本文面向海战场目标搜寻规划问题, 考虑问题求解的快速响应性和实时动态性要求, 提出一种基于Rainbow深度强化学习算法的海战场目标搜寻规划方法, 构建了海战场目标搜寻规划的强化学习模型与深度强化学习算法。案例分析中, 验证了所提算法能够在经过一定训练后稳定收敛, 训练后的强化学习智能体在各种航程条件下的效果均优于常规平行线搜寻模式。下一步研究应考虑多个多种类型搜寻设备同时进行搜寻的情形, 也将考虑更贴合实际海洋搜寻环境的仿真模型, 基于多智能体深度强化学习方法研究海战场多设备目标搜寻规划方法, 进一步提升海战场目标搜寻的成功率和效率。

[1]

OTOTE D A , LI B , AI B , et al . A decision-making algorithm for maritime search and rescue plan

[J]. Sustainability , 2019 , 11 (7 ): 2084 - 2099 .

DOI:10.3390/su11072084

[本文引用: 1]

[2]

JIN Y Q , WANG N , SONG Y T , et al . Optimization model and algorithm to locate rescue bases and allocate rescue vessels in remote oceans

[J]. Soft Computing , 2021 , 25 (4 ): 3317 - 3334 .

DOI:10.1007/s00500-020-05378-6

[本文引用: 2]

[3]

GUO Y , YE Y Q , YANG Q Q , et al . A multi-objective INLP model of sustainable resource allocation for long-range maritime search and rescue

[J]. Sustainability , 2019 , 11 (3 ): 929 - 953 .

DOI:10.3390/su11030929

[本文引用: 1]

[4]

RAHMES M, CHESTER D, HUNT J, et al. Optimizing cooperative cognitive search and rescue UAVs[C]//Proc. of the Autonomous Systems: Sensors, Vehicles, Security and the Internet of Everything, 2018.

[本文引用: 1]

[5]

LIANG X Y , DU X S , WANG G L , et al . A deep reinforcement learning network for traffic light cycle control

[J]. IEEE Trans.on Vehicular Technology , 2019 , 68 (2 ): 1243 - 1253 .

DOI:10.1109/TVT.2018.2890726

[本文引用: 1]

[6]

WANG Y D , LIU H , ZHENG W B , et al . Multi-objective workflow scheduling with deep-Q-network-based multi-agent reinforcement learning

[J]. IEEE Access , 2019 , 7 , 39974 - 39982 .

DOI:10.1109/ACCESS.2019.2902846

[7]

LUONG N C , HOANG D T , GONG S , et al . Applications of deep reinforcement learning in communications and networking: a survey

[J]. IEEE Communications Surveys and Tutorials , 2019 , 21 (4 ): 3133 - 3174 .

DOI:10.1109/COMST.2019.2916583

[8]

MNIH V , KAVUKCUOGLU K , SILVER D , et al . Human-level control through deep reinforcement learning

[J]. Nature , 2015 , 518 (7540 ): 529 - 533 .

DOI:10.1038/nature14236

[本文引用: 2]

[9]

史腾飞 , 王莉 , 黄子蓉 . 序列多智能体强化学习算法

[J]. 模式识别与人工智能 , 2021 , 34 (3 ): 206 - 213 .

URL

[本文引用: 1]

SHI T F , WANG L , HUANG Z R . Sequence to sequence multi-agent reinforcement learning algorithm

[J]. Pattern Recognition and Artificial Intelligence , 2021 , 34 (3 ): 206 - 213 .

URL

[本文引用: 1]

[10]

MNIH V, KAVUKCUOGLU K, SILVER D, et al. Playing atari with deep reinforcement learning[EB/OL]. [2021-10-12]. https://arxiv.org/abs/1312.5602.

[本文引用: 1]

[11]

SCHAUL T, QUAN J, ANTONOGLOU I, et al. Prioritized experience replay[EB/OL]. [2021-10-12]. https://arxiv.org/abs/1511.05952.

[本文引用: 1]

[12]

VAN H H, GUEZ A, SILVER D. Deep reinforcement learning with double q-learning[C]//Proc. of the AAAI conference on Artificial Intelligence, 2016.

[本文引用: 1]

[13]

WANG Z Y, SCHAUL T, HESSEL M, et al. Dueling network architectures for deep reinforcement learning[C]//Proc. of the International Conference on Machine Learning, 2016: 1995-2003.

[本文引用: 1]

[14]

BELLEMARE M G, DABNEY W, MUNOS R. A distributional perspective on reinforcement learning[C]//Proc. of the International Conference on Machine Learning, 2017: 449-458.

[本文引用: 1]

[15]

FORTUNATO M, AZAR M G, PIOT B, et al. Noisy networks for exploration[EB/OL]. [2021-10-12]. https://arxiv.org/abs/1706.10295.

[本文引用: 1]

[16]

HESSEL M, MODAYIL J, VAN H H, et al. Rainbow: combining improvements in deep reinforcement learning[C]//Proc. of the National Conference on Artificial Intelligence, 2018.

[本文引用: 2]

[17]

SUTTON R S , BARTO A G . Reinforcement learning: an introduction [M]. Cambridge : Massachusetts Institute of Technology press , 1998 .

[本文引用: 1]

[18]

SUTTON R S . Learning to predict by the methods of temporal differences

[J]. Machine learning , 1988 , 3 (1 ): 9 - 44 .

[本文引用: 1]

[19]

HAUSKNECHT M, STONE P. Deep recurrent Q-learning for partially observable MDPs[EB/OL]. [2021-10-12]. https://arxiv.org/abs/1507.06527v4.

[本文引用: 1]

[20]

轩永波 , 黄长强 , 吴文超 , 等 . 运动目标的多无人机编队覆盖搜索决策

[J]. 系统工程与电子技术 , 2013 , 35 (3 ): 539 - 544 .

DOI:10.3969/j.issn.1001-506X.2013.03.15

[本文引用: 1]

XUN Y B , HUANG C Q , WU W C , et al . Coverage search strategies for moving targets using multiple unmanned aerial vehicle teams

[J]. Systems Engineering and Electronics , 2013 , 35 (3 ): 539 - 544 .

DOI:10.3969/j.issn.1001-506X.2013.03.15

[本文引用: 1]

[21]

高盈盈. 海上搜救中无人机搜寻规划方法及应用研究[D]. 长沙: 国防科技大学, 2020.

[本文引用: 1]

GAO Y Y. Research on UAV search planning method and application in maritime search and rescue[D]. Changsha: National University of Defense Technology, 2020.

[本文引用: 1]

[22]

XIONG W T , GELDER P V , YANG K W . A decision support method for design and operationalization of search and rescue in maritime emergency

[J]. Ocean Engineering , 2020 , 207 , 107399 - 107415 .

DOI:10.1016/j.oceaneng.2020.107399

[本文引用: 1]

[23]

GALLEGO A J , PERTUSA A , GIL P , et al . Detection of bodies in maritime rescue operations using unmanned aerial vehicles with multispectral cameras

[J]. Journal of Field Robotics , 2019 , 36 (4 ): 782 - 796 .

DOI:10.1002/rob.21849

[本文引用: 3]

[24]

高春庆 , 寇英信 , 李战武 , 等 . 小型无人机协同覆盖侦察路径规划

[J]. 系统工程与电子技术 , 2019 , 41 (6 ): 1294 - 1299 .

URL

[本文引用: 1]

GAO C Q , KOU Y X , LI Z W . Cooperative coverage path planning for small UAVs

[J]. Systems Engineering and Electronics , 2019 , 41 (6 ): 1294 - 1299 .

URL

[本文引用: 1]

[25]

YUE W , GUAN X H , WANG L Y . A novel searching method using reinforcement learning scheme for multi-UAVs in unknown environments

[J]. Applied Sciences , 2019 , 9 (22 ): 4964 - 4978 .

DOI:10.3390/app9224964

[本文引用: 1]

[26]

CHENG Y , ZHANG W D . Concise deep reinforcement learning obstacle avoidance for underactuated unmanned marine vessels

[J]. Neurocomputing , 2018 , 272 , 63 - 73 .

DOI:10.1016/j.neucom.2017.06.066

[本文引用: 1]

[27]

LI R P , ZHAO Z F , SUN Q , et al . Deep reinforcement learning for resource management in network slicing

[J]. IEEE Access , 2018 , 6 , 74429 - 74441 .

DOI:10.1109/ACCESS.2018.2881964

[本文引用: 1]

[28]

TAMPUU A , MATⅡSEN T , KODELJA D , et al . Multiagent cooperation and competition with deep reinforcement learning

[J]. Plos One , 2017 , 12 (4 ): e0172395 .

[本文引用: 1]

A decision-making algorithm for maritime search and rescue plan

1

2019

... 海战场越来越成为大国军事对抗的主战场, 海战场目标搜寻是海上作战的重要构成要素, 是待救军事人员的最后一道希望, 随着以人为本理念的深入, 海上搜救问题得到越来越多的关注.当遇险目标位置不明时, 须进行海上搜寻.海上搜寻在整个搜救过程中是最昂贵、最危险和最复杂的部分, 也是发现和救助遇险目标的唯一途径.海战场搜救行动成功与否的关键在于搜寻预案的制定, 目前实际搜救过程中搜寻方案的制定过多依赖于主观决策者的主观判断和历史的经验指导, 行动的组织存在一定的盲目性, 搜寻任务规划缺乏系统性.因此, 研究定量化的搜寻预案设计方法与技术, 建立科学、高效、易实施的海战场搜寻方法至关重要[1 ] . ...

Optimization model and algorithm to locate rescue bases and allocate rescue vessels in remote oceans

2

2021

... 在调研过程中发现, 海战场待搜寻目标具有存活时间短、待搜寻区域广、探测概率低、漂流轨迹难以预测等特征, 要求目标搜寻规划方法必须能够快速响应, 且支持实时规划[2 ] .但是当前我国海战场目标搜寻能力距离国际先进水平尚有一定差距[3 ] .在实际搜救过程中, 针对未知位置的海上目标搜寻问题, 大多仍然采用机械的覆盖搜寻方法, 效率较低, 且难以准确量化实时调整搜寻方案.在研究方面, 传统的目标搜寻规划求解方法, 如精确优化算法、启发式算法、元启发式算法等只能针对明确的搜寻场景进行求解, 而无法应对搜寻态势实时变化的情形[4 ] .且由于无人机的快速发展, 传统搜寻模式和研究方法均不太适用于基于无人机的灵活多变的搜寻模式需求.而强化学习是一种不断与环境交互反馈, 调整自身策略以应对环境变化的动态规划方法, 得到了多种实际场景的应用验证[5 -8 ] , 适用于海战场目标搜寻路径规划问题的优化求解.因此, 可结合强化学习等智能方法拓展搜寻方案的制定方法, 设计海战场目标搜寻的快速响应算法, 提高搜寻效率, 进而提升海上作战效能. ...

... 针对本文所提出的算法, 与当前海上搜救实际业务中常用的平行搜寻模式[2 ] 和基于遗传算法(genetic algorithm, GA)获取的近似最优搜寻路径进行对比.在相同的初始位置(1, 1)和相同的搜寻环境下对比搜索效果, 如图 11 所示. ...

A multi-objective INLP model of sustainable resource allocation for long-range maritime search and rescue

1

2019

... 在调研过程中发现, 海战场待搜寻目标具有存活时间短、待搜寻区域广、探测概率低、漂流轨迹难以预测等特征, 要求目标搜寻规划方法必须能够快速响应, 且支持实时规划[2 ] .但是当前我国海战场目标搜寻能力距离国际先进水平尚有一定差距[3 ] .在实际搜救过程中, 针对未知位置的海上目标搜寻问题, 大多仍然采用机械的覆盖搜寻方法, 效率较低, 且难以准确量化实时调整搜寻方案.在研究方面, 传统的目标搜寻规划求解方法, 如精确优化算法、启发式算法、元启发式算法等只能针对明确的搜寻场景进行求解, 而无法应对搜寻态势实时变化的情形[4 ] .且由于无人机的快速发展, 传统搜寻模式和研究方法均不太适用于基于无人机的灵活多变的搜寻模式需求.而强化学习是一种不断与环境交互反馈, 调整自身策略以应对环境变化的动态规划方法, 得到了多种实际场景的应用验证[5 -8 ] , 适用于海战场目标搜寻路径规划问题的优化求解.因此, 可结合强化学习等智能方法拓展搜寻方案的制定方法, 设计海战场目标搜寻的快速响应算法, 提高搜寻效率, 进而提升海上作战效能. ...

1

... 在调研过程中发现, 海战场待搜寻目标具有存活时间短、待搜寻区域广、探测概率低、漂流轨迹难以预测等特征, 要求目标搜寻规划方法必须能够快速响应, 且支持实时规划[2 ] .但是当前我国海战场目标搜寻能力距离国际先进水平尚有一定差距[3 ] .在实际搜救过程中, 针对未知位置的海上目标搜寻问题, 大多仍然采用机械的覆盖搜寻方法, 效率较低, 且难以准确量化实时调整搜寻方案.在研究方面, 传统的目标搜寻规划求解方法, 如精确优化算法、启发式算法、元启发式算法等只能针对明确的搜寻场景进行求解, 而无法应对搜寻态势实时变化的情形[4 ] .且由于无人机的快速发展, 传统搜寻模式和研究方法均不太适用于基于无人机的灵活多变的搜寻模式需求.而强化学习是一种不断与环境交互反馈, 调整自身策略以应对环境变化的动态规划方法, 得到了多种实际场景的应用验证[5 -8 ] , 适用于海战场目标搜寻路径规划问题的优化求解.因此, 可结合强化学习等智能方法拓展搜寻方案的制定方法, 设计海战场目标搜寻的快速响应算法, 提高搜寻效率, 进而提升海上作战效能. ...

A deep reinforcement learning network for traffic light cycle control

1

2019

... 在调研过程中发现, 海战场待搜寻目标具有存活时间短、待搜寻区域广、探测概率低、漂流轨迹难以预测等特征, 要求目标搜寻规划方法必须能够快速响应, 且支持实时规划[2 ] .但是当前我国海战场目标搜寻能力距离国际先进水平尚有一定差距[3 ] .在实际搜救过程中, 针对未知位置的海上目标搜寻问题, 大多仍然采用机械的覆盖搜寻方法, 效率较低, 且难以准确量化实时调整搜寻方案.在研究方面, 传统的目标搜寻规划求解方法, 如精确优化算法、启发式算法、元启发式算法等只能针对明确的搜寻场景进行求解, 而无法应对搜寻态势实时变化的情形[4 ] .且由于无人机的快速发展, 传统搜寻模式和研究方法均不太适用于基于无人机的灵活多变的搜寻模式需求.而强化学习是一种不断与环境交互反馈, 调整自身策略以应对环境变化的动态规划方法, 得到了多种实际场景的应用验证[5 -8 ] , 适用于海战场目标搜寻路径规划问题的优化求解.因此, 可结合强化学习等智能方法拓展搜寻方案的制定方法, 设计海战场目标搜寻的快速响应算法, 提高搜寻效率, 进而提升海上作战效能. ...

Multi-objective workflow scheduling with deep-Q-network-based multi-agent reinforcement learning

0

2019

Applications of deep reinforcement learning in communications and networking: a survey

0

2019

Human-level control through deep reinforcement learning

2

2015

... 在调研过程中发现, 海战场待搜寻目标具有存活时间短、待搜寻区域广、探测概率低、漂流轨迹难以预测等特征, 要求目标搜寻规划方法必须能够快速响应, 且支持实时规划[2 ] .但是当前我国海战场目标搜寻能力距离国际先进水平尚有一定差距[3 ] .在实际搜救过程中, 针对未知位置的海上目标搜寻问题, 大多仍然采用机械的覆盖搜寻方法, 效率较低, 且难以准确量化实时调整搜寻方案.在研究方面, 传统的目标搜寻规划求解方法, 如精确优化算法、启发式算法、元启发式算法等只能针对明确的搜寻场景进行求解, 而无法应对搜寻态势实时变化的情形[4 ] .且由于无人机的快速发展, 传统搜寻模式和研究方法均不太适用于基于无人机的灵活多变的搜寻模式需求.而强化学习是一种不断与环境交互反馈, 调整自身策略以应对环境变化的动态规划方法, 得到了多种实际场景的应用验证[5 -8 ] , 适用于海战场目标搜寻路径规划问题的优化求解.因此, 可结合强化学习等智能方法拓展搜寻方案的制定方法, 设计海战场目标搜寻的快速响应算法, 提高搜寻效率, 进而提升海上作战效能. ...

... 然而, DQN基于使用单个价值网络的训练效率较低, 且完整的分布信息很大程度上被丢失[8 ] .为了解决DQN算法本身存在的不足, 后续研究者对其进行了大量改进, 如优先Q网络[11 ] 、双Q网络[12 ] 、竞争Q网络结构[13 ] 等.近年, 也有学者提出分布式Q学习算法[14 ] 、噪声网络结构[15 ] .但是以上这些算法都可以在某个方面提升DQN的性能, 而且都是基于同一个网络框架.Hessel等将上述所有方法进行整合, 提出通用性很强的Rainbow算法[16 ] , 引入多步学习机制[17 -18 ] , 可以在训练前期更准确地估计目标价值以加快训练速度, 在学习效率和学习效果上都优于其他算法[19 ] . ...

序列多智能体强化学习算法

1

2021

... 当前的深度强化学习方法一般分为两种: 价值学习和策略学习[9 ] .为了能在有限计算条件下, 快速获得较为精确的计算结果, 本文将海战场待搜寻区域进行网格化处理, 同时将搜寻主体的动作空间离散化, 缩小决策空间, 适用于采用基于价值的学习方法.基于价值的深度强化学习方法代表性算法是深度Q网络(deep Q-network, DQN)算法[10 ] . ...

序列多智能体强化学习算法

1

2021

... 当前的深度强化学习方法一般分为两种: 价值学习和策略学习[9 ] .为了能在有限计算条件下, 快速获得较为精确的计算结果, 本文将海战场待搜寻区域进行网格化处理, 同时将搜寻主体的动作空间离散化, 缩小决策空间, 适用于采用基于价值的学习方法.基于价值的深度强化学习方法代表性算法是深度Q网络(deep Q-network, DQN)算法[10 ] . ...

1

... 当前的深度强化学习方法一般分为两种: 价值学习和策略学习[9 ] .为了能在有限计算条件下, 快速获得较为精确的计算结果, 本文将海战场待搜寻区域进行网格化处理, 同时将搜寻主体的动作空间离散化, 缩小决策空间, 适用于采用基于价值的学习方法.基于价值的深度强化学习方法代表性算法是深度Q网络(deep Q-network, DQN)算法[10 ] . ...

1

... 然而, DQN基于使用单个价值网络的训练效率较低, 且完整的分布信息很大程度上被丢失[8 ] .为了解决DQN算法本身存在的不足, 后续研究者对其进行了大量改进, 如优先Q网络[11 ] 、双Q网络[12 ] 、竞争Q网络结构[13 ] 等.近年, 也有学者提出分布式Q学习算法[14 ] 、噪声网络结构[15 ] .但是以上这些算法都可以在某个方面提升DQN的性能, 而且都是基于同一个网络框架.Hessel等将上述所有方法进行整合, 提出通用性很强的Rainbow算法[16 ] , 引入多步学习机制[17 -18 ] , 可以在训练前期更准确地估计目标价值以加快训练速度, 在学习效率和学习效果上都优于其他算法[19 ] . ...

1

... 然而, DQN基于使用单个价值网络的训练效率较低, 且完整的分布信息很大程度上被丢失[8 ] .为了解决DQN算法本身存在的不足, 后续研究者对其进行了大量改进, 如优先Q网络[11 ] 、双Q网络[12 ] 、竞争Q网络结构[13 ] 等.近年, 也有学者提出分布式Q学习算法[14 ] 、噪声网络结构[15 ] .但是以上这些算法都可以在某个方面提升DQN的性能, 而且都是基于同一个网络框架.Hessel等将上述所有方法进行整合, 提出通用性很强的Rainbow算法[16 ] , 引入多步学习机制[17 -18 ] , 可以在训练前期更准确地估计目标价值以加快训练速度, 在学习效率和学习效果上都优于其他算法[19 ] . ...

1

... 然而, DQN基于使用单个价值网络的训练效率较低, 且完整的分布信息很大程度上被丢失[8 ] .为了解决DQN算法本身存在的不足, 后续研究者对其进行了大量改进, 如优先Q网络[11 ] 、双Q网络[12 ] 、竞争Q网络结构[13 ] 等.近年, 也有学者提出分布式Q学习算法[14 ] 、噪声网络结构[15 ] .但是以上这些算法都可以在某个方面提升DQN的性能, 而且都是基于同一个网络框架.Hessel等将上述所有方法进行整合, 提出通用性很强的Rainbow算法[16 ] , 引入多步学习机制[17 -18 ] , 可以在训练前期更准确地估计目标价值以加快训练速度, 在学习效率和学习效果上都优于其他算法[19 ] . ...

1

... 然而, DQN基于使用单个价值网络的训练效率较低, 且完整的分布信息很大程度上被丢失[8 ] .为了解决DQN算法本身存在的不足, 后续研究者对其进行了大量改进, 如优先Q网络[11 ] 、双Q网络[12 ] 、竞争Q网络结构[13 ] 等.近年, 也有学者提出分布式Q学习算法[14 ] 、噪声网络结构[15 ] .但是以上这些算法都可以在某个方面提升DQN的性能, 而且都是基于同一个网络框架.Hessel等将上述所有方法进行整合, 提出通用性很强的Rainbow算法[16 ] , 引入多步学习机制[17 -18 ] , 可以在训练前期更准确地估计目标价值以加快训练速度, 在学习效率和学习效果上都优于其他算法[19 ] . ...

1

... 然而, DQN基于使用单个价值网络的训练效率较低, 且完整的分布信息很大程度上被丢失[8 ] .为了解决DQN算法本身存在的不足, 后续研究者对其进行了大量改进, 如优先Q网络[11 ] 、双Q网络[12 ] 、竞争Q网络结构[13 ] 等.近年, 也有学者提出分布式Q学习算法[14 ] 、噪声网络结构[15 ] .但是以上这些算法都可以在某个方面提升DQN的性能, 而且都是基于同一个网络框架.Hessel等将上述所有方法进行整合, 提出通用性很强的Rainbow算法[16 ] , 引入多步学习机制[17 -18 ] , 可以在训练前期更准确地估计目标价值以加快训练速度, 在学习效率和学习效果上都优于其他算法[19 ] . ...

2

... 然而, DQN基于使用单个价值网络的训练效率较低, 且完整的分布信息很大程度上被丢失[8 ] .为了解决DQN算法本身存在的不足, 后续研究者对其进行了大量改进, 如优先Q网络[11 ] 、双Q网络[12 ] 、竞争Q网络结构[13 ] 等.近年, 也有学者提出分布式Q学习算法[14 ] 、噪声网络结构[15 ] .但是以上这些算法都可以在某个方面提升DQN的性能, 而且都是基于同一个网络框架.Hessel等将上述所有方法进行整合, 提出通用性很强的Rainbow算法[16 ] , 引入多步学习机制[17 -18 ] , 可以在训练前期更准确地估计目标价值以加快训练速度, 在学习效率和学习效果上都优于其他算法[19 ] . ...

... 2018年, DeepMind在DQN的基础上提出了一种融合6个改进机制的基于价值的深度强化学习方法: Rainbow.其中融合的改进机制分别为: 双Q网络、优先经验回放、对决网络、多步学习、分布式学习、噪声网络.Rainbow被证明在多个基准测试中优于其他基于价值的深度强化学习算法[16 ] .因此, 本节采用Rainbow的思想设计海战场目标搜寻规划的深度强化学习算法. ...

1

1998

... 然而, DQN基于使用单个价值网络的训练效率较低, 且完整的分布信息很大程度上被丢失[8 ] .为了解决DQN算法本身存在的不足, 后续研究者对其进行了大量改进, 如优先Q网络[11 ] 、双Q网络[12 ] 、竞争Q网络结构[13 ] 等.近年, 也有学者提出分布式Q学习算法[14 ] 、噪声网络结构[15 ] .但是以上这些算法都可以在某个方面提升DQN的性能, 而且都是基于同一个网络框架.Hessel等将上述所有方法进行整合, 提出通用性很强的Rainbow算法[16 ] , 引入多步学习机制[17 -18 ] , 可以在训练前期更准确地估计目标价值以加快训练速度, 在学习效率和学习效果上都优于其他算法[19 ] . ...

Learning to predict by the methods of temporal differences

1

1988

... 然而, DQN基于使用单个价值网络的训练效率较低, 且完整的分布信息很大程度上被丢失[8 ] .为了解决DQN算法本身存在的不足, 后续研究者对其进行了大量改进, 如优先Q网络[11 ] 、双Q网络[12 ] 、竞争Q网络结构[13 ] 等.近年, 也有学者提出分布式Q学习算法[14 ] 、噪声网络结构[15 ] .但是以上这些算法都可以在某个方面提升DQN的性能, 而且都是基于同一个网络框架.Hessel等将上述所有方法进行整合, 提出通用性很强的Rainbow算法[16 ] , 引入多步学习机制[17 -18 ] , 可以在训练前期更准确地估计目标价值以加快训练速度, 在学习效率和学习效果上都优于其他算法[19 ] . ...

1

... 然而, DQN基于使用单个价值网络的训练效率较低, 且完整的分布信息很大程度上被丢失[8 ] .为了解决DQN算法本身存在的不足, 后续研究者对其进行了大量改进, 如优先Q网络[11 ] 、双Q网络[12 ] 、竞争Q网络结构[13 ] 等.近年, 也有学者提出分布式Q学习算法[14 ] 、噪声网络结构[15 ] .但是以上这些算法都可以在某个方面提升DQN的性能, 而且都是基于同一个网络框架.Hessel等将上述所有方法进行整合, 提出通用性很强的Rainbow算法[16 ] , 引入多步学习机制[17 -18 ] , 可以在训练前期更准确地估计目标价值以加快训练速度, 在学习效率和学习效果上都优于其他算法[19 ] . ...

运动目标的多无人机编队覆盖搜索决策

1

2013

... 将任务区域E划分成L x L y 图 1 所示.每个网格都是独立的, 将每个网格的中心点坐标作为该网格的位置坐标.假设初始先验信息已知, 每个栅格(m , n )赋予一定的目标包含概率(probability of contain, POC)初始值p mn [20 ] , (m , n )的取值范围为m ∈{1, 2, …, L x n ∈{1, 2, …, L y

运动目标的多无人机编队覆盖搜索决策

1

2013

... 将任务区域E划分成L x L y 图 1 所示.每个网格都是独立的, 将每个网格的中心点坐标作为该网格的位置坐标.假设初始先验信息已知, 每个栅格(m , n )赋予一定的目标包含概率(probability of contain, POC)初始值p mn [20 ] , (m , n )的取值范围为m ∈{1, 2, …, L x n ∈{1, 2, …, L y

1

... 待搜寻目标的漂流轨迹预测是海上搜救的一个重要研究方向, 在实际搜寻过程中, 每个栅格的目标存在概率会随着海流、海浪、潮汐等影响因素的改变而变化, 实时获取POC矩阵需要结合海上部署传感器、气象卫星等多源信息的处理, 计算复杂度较高[21 ] .本文重点验证算法的适用性和有效性, 简化了实时变化因素.为了降低计算复杂性, 仅考虑搜寻行动对目标存在概率值所产生的后验影响, 忽略海洋环境因素的影响. ...

1

... 待搜寻目标的漂流轨迹预测是海上搜救的一个重要研究方向, 在实际搜寻过程中, 每个栅格的目标存在概率会随着海流、海浪、潮汐等影响因素的改变而变化, 实时获取POC矩阵需要结合海上部署传感器、气象卫星等多源信息的处理, 计算复杂度较高[21 ] .本文重点验证算法的适用性和有效性, 简化了实时变化因素.为了降低计算复杂性, 仅考虑搜寻行动对目标存在概率值所产生的后验影响, 忽略海洋环境因素的影响. ...

A decision support method for design and operationalization of search and rescue in maritime emergency

1

2020

... 式中: v 为无人机i 的飞行速度; z 为无人机i 的飞行时间; l 为无人机i 在时间内搜寻航行的总路程; w 为无人机i 的探测宽度即扫海宽度; A 为搜寻栅格单元的面积; j 为搜寻单元数(j =1, 2, …, xy ).式(3)中,扫海宽度是经过大量的搜救实验以及通过对历史搜救案例的总结得出的, 一般情况下, 可以通过查表得出[22 ] . ...

Detection of bodies in maritime rescue operations using unmanned aerial vehicles with multispectral cameras

3

2019

... 常规的海战场目标搜寻方式仅确定待搜寻区域, 再利用平行线等固定搜寻模式来规划搜寻路径, 导致搜寻成功率(probability of success, POS)较低[23 ] .为此, 有必要以目标存在概率模型为基础, 在待搜寻区域E内规划搜寻路径. ...

... 海洋监测中心通常基于蒙特卡罗随机粒子法进行漂流模拟得到海上遇险目标的POC矩阵, 并利用栅格法将待搜寻海域划分为若干子海域, 构建二维海洋环境栅格地图[23 ] .将目标海域E划分成L x L y m , n )一定的初始POC值p mn m , n )都有一个属性值r , 表示子区域(m , n )的状态值, r mn t )=-1表示t 时刻以前子区域(m , n )已被无人机搜寻过, r mn t )=1表示t 时刻下无人机正处于子区域(m , n ), r mn t )=0表示t时刻及以前子区域(m , n )均未被搜寻过. ...

... {R 1 , R 2 , …,RL }表示无人机在一个回合(L 步)中每一步的即时奖励集合.为尽量避免无人机重复往返同一子海域, 设置已搜寻过的海域搜寻效益奖励为r punish .同时, 为避免无人机绕出目标海域或者进入危险区和障碍区, 同样设置越界惩罚为r punish .随着搜寻时间的增加, 子区域(m , n )的p mn 将以一定比例g (0 < g < 1)逐渐衰减, g 值在搜寻开始前根据搜救情况具体设定, 设计第L 步的即时奖励函数[23 ] 如下: ...

小型无人机协同覆盖侦察路径规划

1

2019

... 动作空间的定义会影响到无人机路径规划的效果.如图 2 所示, 将360°划分n 等份, 角度间隔α =360°/n .假设n =8, 则α =45°.在每个决策时间点, 无人机可以采取以下行动, 比如: 左偏αi k 、直行或右偏αi k .为方便建模, 无人机i 的动作空间可表示为ai k =[ui k ], 动作决策变量ai k ={1, 2, …, 8}, 分别表示: 上、右上、右、右下、下、左下、左和左上[24 ] . ...

小型无人机协同覆盖侦察路径规划

1

2019

... 动作空间的定义会影响到无人机路径规划的效果.如图 2 所示, 将360°划分n 等份, 角度间隔α =360°/n .假设n =8, 则α =45°.在每个决策时间点, 无人机可以采取以下行动, 比如: 左偏αi k 、直行或右偏αi k .为方便建模, 无人机i 的动作空间可表示为ai k =[ui k ], 动作决策变量ai k ={1, 2, …, 8}, 分别表示: 上、右上、右、右下、下、左下、左和左上[24 ] . ...

A novel searching method using reinforcement learning scheme for multi-UAVs in unknown environments

1

2019

... 在强化学习过程中, 无人机搜寻获取奖励值的大小不仅取决于学习算法的优劣, 也与奖励函数的定义密切相关[25 ] .强化学习算法通过设置奖励函数对无人机所做动作进行定量化评价, 引导整个无人机的搜寻路径学习过程.强化学习算法的总体目标是引导无人机获取最大的累计奖励值, 也就是找到一条由起始点至目标点的最优[26 ] .因此, 设计合适的奖励函数对于无人机在不同环境状态下的学习效果好坏具有重要意义[27 ] . ...

Concise deep reinforcement learning obstacle avoidance for underactuated unmanned marine vessels

1

2018

... 在强化学习过程中, 无人机搜寻获取奖励值的大小不仅取决于学习算法的优劣, 也与奖励函数的定义密切相关[25 ] .强化学习算法通过设置奖励函数对无人机所做动作进行定量化评价, 引导整个无人机的搜寻路径学习过程.强化学习算法的总体目标是引导无人机获取最大的累计奖励值, 也就是找到一条由起始点至目标点的最优[26 ] .因此, 设计合适的奖励函数对于无人机在不同环境状态下的学习效果好坏具有重要意义[27 ] . ...

Deep reinforcement learning for resource management in network slicing

1

2018

... 在强化学习过程中, 无人机搜寻获取奖励值的大小不仅取决于学习算法的优劣, 也与奖励函数的定义密切相关[25 ] .强化学习算法通过设置奖励函数对无人机所做动作进行定量化评价, 引导整个无人机的搜寻路径学习过程.强化学习算法的总体目标是引导无人机获取最大的累计奖励值, 也就是找到一条由起始点至目标点的最优[26 ] .因此, 设计合适的奖励函数对于无人机在不同环境状态下的学习效果好坏具有重要意义[27 ] . ...

Multiagent cooperation and competition with deep reinforcement learning

1

2017

... 本文针对海上目标搜寻的实际情况, 基于最优搜寻理论中POC和POS等重要参数概念设立奖励机制, 并与稀疏奖赏函数相结合设计碰撞惩罚机制[28 ] .且在模型训练过程中奖励分为两个部分, 一个是针对每个行动的即时奖励, 另一个是针对整个行动回合表现的回合奖励. ...